📌Multi-model

- Multi modal learning :다양한 형태의 데이터 (이미지, 텍스트,음성 등)을 input을 받아 한 번에 학습시키는 것

- Multi modal learning의 문제점

- 데이터별 상이한 표현

: 음성 1d , 이미지 2d , 텍스트는 embedding을 통한 단어별 feature vector로 표현하는 등 데이터별 표현방법이 다르다. - feature space 간 불균형

: 예를 들어 text와 image 데이터 사이의 관계가 m : n 다대다 구조 - 편향된 학습법

: 쉬운 특정 데이터 타입에 편향되어 학습이 이뤄질 수 있다.

- 데이터별 상이한 표현

- Multi modal learning의 종류

1. Matching

ex ) Image tagging , Image&food recipe retrieval

2. Translalting

ex ) Image captioning , show and tell , text to image by generative model

3. Referencing

ex ) visual question answerling

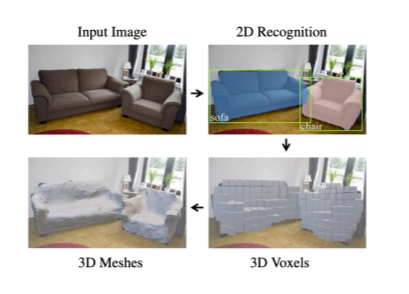

📌 3D Understanding

- 3D의 중요성

우리가 사는 세계는 3D이기 때문이다.

우리는 3D 세상을 사영시켜 2D image로 본다.

- 3D의 표현법

2D image의 표현법과는 다르다.

여러 관점에서 바라봐 보간하는 multi-view images부터 포인트들을 하나의 정점으로 나타내고 점들끼리 삼각형으로 잇는 Mesh법까지 다양하다.

- 3D tasks

3d recognition , detection , segemtation 등 2d와 동일하게 여러가지 task를 할 수 있다.

주로 "자율주행"에서 특히 많이 쓰이는 거 같다.

3d 이미지를 생성할 수도 있다.

Mesg RCNN의 경우 MaskRCNN에서 mask branch를 mesh로 바꿔준다.

하루 정리

1시간 짜리 강의에 논문만 15편이 소개된다.

이걸 하루 안에 소화하는 건 무리고, 되지도 않는다.

오늘의 학습목표는 multi-modal, 3d와 같은 평소 접해보지 않은 개념들에 대해 알고, 아 이런 것도 있구나 느끼기!

추후에 쓸 일이 있으면 "아 공부할 때 이런 것도 있던 거 같은데,,?" 하면서 찾아볼 수만 있다면 150% 성공이라 생각한다.

최근에 슬럼프? (슬럼프는 잘하는 사람한테만 오는 건데 ...? 그럼 나한텐 온 건 뭐야;ㅜ) 비슷하게 왔었는데 조원들 덕분에 극복했다.

우리 중에 유일한 j인 보현님의 스케줄대로 공부하기 위해서 아침 10시부터 줌을 키고 다같이 공부한다.

🎉 알렉스터디카페 개장 🎉

혼자였다면 10시에 출첵만 하고 잠들었을텐데, 조원들 덕분에 아침부터 책상 앞에 앉게 된다.

아침 10시부터 꾸준히, 해야되는 일부터 공부하는 보현님 존경,,, 아침햇살 같은 조원🌞

수업시간에 배운 hourglass를 이용해 keypoint detection을 다시 학습시켜봤는데 흠,,,

val에 대해선 꽤 정확히 잘 그려지는데,,, test 점수는 최악이다.

augmentation을 추가하고, batch를 줄이더라도 resolution을 높히는 방식으로 다시 접근해봐야겠다.

'Naver Ai Boostcamp' 카테고리의 다른 글

| [Day 37] 모델의 시공간 & 알뜰히 (0) | 2021.03.27 |

|---|---|

| [DAY 36] OMG 왜 안했누 (0) | 2021.03.26 |

| [DAY 34] Instance/Panoptic segmentation & Conditional generative model (2) | 2021.03.17 |

| [DAY 33] Object Detection & CNN visualization (0) | 2021.03.17 |

| [DAY 31] Image classfication1 & annotation data efficient learning (0) | 2021.03.13 |