📌 학습 목표

학습 정리하기- Augmentation 뿌수기 -> 무수면 하더라도 무조건 하자

📌 학습 정리

오늘 강의는 competition이 익숙하지 않은 나 같은 사람한테 도움이 많이 될 거 같다.

1. RandomSeed 고정 -> 매번 이걸로 고통받는 나,,, 항상 1순위로 확인하려고한다.

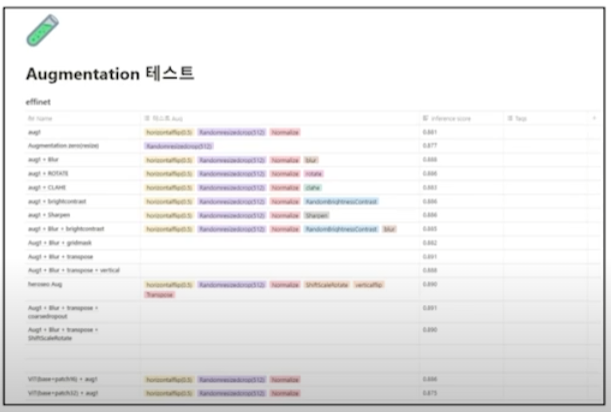

2. 실험기록

아 너무 이쁜 거 같다. 한 눈에 보기도 좋고.

pstage3도 나름 잘 하고 있지만, 이게 더 좋아보인다. pstage4부터 이렇게 해야지!!

3. 실험은 한 번에 하나씩! => 지난 대회 1등이었던 현규님도 이렇게 하셨다고 했다.

뭐가 효과적이었는지 알아보기 위해 (*중첩효과 싫어요ㅠ) 한 번에 하나씩!

2.2 Validaiton이 중요하다

-> 제출을 하지 않아도 모델의 성능을 평가할 수 있고, 리더보드의 성능에 오버피팅 되지 않도록 도와준다.

-> 내 validation은 뭔가 이상하다... val score가 낮은데 LB는 높고,,, 뭔가 문제가 있는 거 같다.

2.3 Augmentation

항상 느끼지만 도메인에 맞는 Augmentation 필수!

모델과 물아일체가 되어 어떤 변형된 이미지를 받았을 때 잘 학습할 수 있을지 고려해보자.

- CUTOUT

- GridMask

- CUTMIX

- SnapMix

2.4 SotaModel

- 이건 mmsegmentation에 잘 나와있으니 PASS

- 개인적으로 SOTA논문에서 model도 model이지만 잔기술들(loss같은 ..?)그런 아이디어 얻어오는 것도 중요한 것 같다.

2.5 Scheduler

- CosineAnnealingLR

- ReduceLROnPlateau

- Gradual Warmup : 개인적으로 cosine + warmup을 사용한다.

2.6 Batch size

- Gradient Accumulation : 이것도 도전해보려고 했던 것 중 하나!

- mixed precision : ㅠㅠ,,, 내가 다시 구해줄게

2.7 optimizer

- Lookahead optimizer : 얘는 처음보는데 신기하구만 ,,, 주말에 좀 더 찾아보자.

2.8 Ensemble

- Stochastic Weight Averaging : 이름을 많이 들어본 녀석인데,,, 신기하구만

- Seed Ensemble : 헠 보윤보현님이 하시길래 장난인 줄 알았는데 진짜 있었네

- Resize Ensemble : Multi scale inference로 일종의 TTA

2.9 Pseudo Labeling

- 얘도 궁금했는데 이번 기회에 해봐야지!!~~

수업의 핵심은

"GPU를 쉬게 하지마라! 1점이라도 올리고 싶다면 남들이 해본 건 다 해보고 안 해본 거까지 다 해봐야한다. "

📌 피어 세션

피어세션 항상 감탄 나온다,,, 오늘 또 새삼 느꼈지만 이런 사람들과 한 조가 될 수 있던 나는 운이 좋은 거 같다. 😜

오늘 간단하게 실험일지에 있는 거 브리핑? 느낌으로 얘기하고 질문 주고 받고했다.

효진님께서 내 실험 결과 잘 보셨다고 CE랑 같이 섞어쓰면 좋겠다고 말씀해주셨다.

그리고 내가 focal loss 쓰면서 바보같이 alpha, gamma를 안 줬는데 이 점을 홍엽님이 잡아주셨다.

확실히 실험 결과를 visualizatoin 하니까 내 실험에 대한 근거가 탄탄히 잘 잡히는 기분이다.

pstage1~3 통틀어서 가장 재밌게 실험하고 있는 중 🤗🤗🤗🤗🤗

유지님이랑 성훈님은 오늘 PSPNET , SETR 발표를 해주셨다.

효진님께서 DECODER보다 ENCODER 더 중요하다고 하셨던 게 이해가 안갔는데, 논문설명을 듣고 효진님 설명을 들으니 오오,,,, 그런 거 같다. DECODER에서는 학습을 할 수 있는 부분이 많지가 않다. 효진님 통찰력 👍👍

SETR 논문은 전체 다 읽진 못하고 간단하게 읽었는데 확실히 아이디어가 신선한 거 같다. (아닌가? 내 기준 신선함)

mmsegmentation에서 제공하고 있으니 주말동안 SETR 연구해보자.

예전에 기민님이 transformer모델이랑 앙상블하면 성능이 오른다고 하셨었는데,,, 기민님은 잘 사시려나 갑자기 궁금하다. 의식의 흐름 피어세션 리뷰 끝!

오늘의 알고리즘 문제는 programmers.co.kr/learn/courses/30/lessons/64062

코딩테스트 연습 - 징검다리 건너기

[2, 4, 5, 3, 2, 1, 4, 2, 5, 1] 3 3

programmers.co.kr

블로그에 리뷰도 완료해놨다.

앗, 자소서 써야 되는데 !

'Naver Ai Boostcamp' 카테고리의 다른 글

| Pstage3 Day ? ] Develop your model! (0) | 2021.05.15 |

|---|---|

| Day4 ] (0) | 2021.04.30 |

| Pstage3_Day3 ] (0) | 2021.04.29 |

| Pstage3_Day2 ] FCN의 한계를 극복하려고 한 논문들 (0) | 2021.04.28 |

| Pstage3_Day1 ] Semantic Segmentation의 기초와 이해 (0) | 2021.04.26 |